Wyścig technologiczny w dziedzinie kwantowej rozpoczął się w latach dziewięćdziesiątych, ale kilka lat temu stał się również wyścigiem geopolitycznym.

Żyjemy w wyjątkowym momencie globalnego wyścigu o zbudowanie komputera kwantowego. Nie trzeba daleko szukać, aby znaleźć przykład: dyrektor generalny IonQ, Niccolo de Masi, oświadczył niedawno przed Kongresem Stanów Zjednoczonych, że „rozpoczęła się komercyjna era informatyki kwantowej”, twierdząc, że technologia rozwija się wystarczająco szybko, aby zmienić potęgę gospodarczą, zdolności przemysłowe i planowanie bezpieczeństwa narodowego.

Co tydzień jakiś producent ogłasza nowe osiągnięcia, które przybliżają długo oczekiwaną przewagę kwantową, czyli moment, w którym komputer kwantowy przewyższy najpotężniejsze klasyczne komputery, podsycając poczucie, że jego nadejście jest nieuchronne. Na przykład francusko-niemieckie konsorcjum Quandela i Attocube Systems GmbH wprowadziło na rynek Lucy, 12-kubitowy fotoniczny komputer kwantowy – najpotężniejszy w swojej kategorii do tej pory – który po zintegrowaniu z superkomputerem Joliot-Curie umożliwi wykonywanie hybrydowych kwantowo-klasycznych przepływów pracy dla badań i przemysłu.

IBM ogłosił natomiast wprowadzenie Quantum Nighthawk, swojego najbardziej zaawansowanego jak dotąd procesora kwantowego, zaprojektowanego z architekturą zoptymalizowaną do współpracy z wysokowydajnym oprogramowaniem kwantowym i pozycjonowanego tak, aby zapewnić przewagę kwantową w przyszłym roku. W Chinach firma półprzewodnikowa CHIPX zaprezentowała chip kwantowy, który według niej jest nawet 1000 razy szybszy niż procesory graficzne Nvidia w przetwarzaniu obciążeń AI.

Google ogłosił również znaczący postęp w zakresie Quantum Echoes, nowego algorytmu, który osiągnął pierwszą weryfikowalną przewagę kwantową w potencjalnie użytecznym problemie. Algorytm, uruchomiony na 105-kubitowym chipie Willow, wykonał określone obliczenia około 13 000 razy szybciej niż najlepszy dostępny algorytm klasyczny. Porównanie przeprowadzono, uruchamiając go na jednym z najpotężniejszych superkomputerów na świecie.

Komputer kwantowy jest zasadniczo komputerem działającym jak komputer klasyczny, ale wykorzystującym wykładniczą moc mechaniki kwantowej i zdolnym do jednoczesnego badania dużej liczby możliwości. Chociaż ostatni boom może sprawiać takie wrażenie, to właśnie w latach dziewięćdziesiątych komputer kwantowy zaczął nabierać kształtu i powstały jego podstawy technologiczne: zdefiniowano kubit lub bit kwantowy, zbadano kwantowy rozkład informacji i opracowano pierwsze prototypy. Równolegle ustanowiono teoretycznie pojęcie przewagi kwantowej: zdolność algorytmu kwantowego do przewyższenia setki lub tysiące razy wydajność dowolnego algorytmu klasycznego. Wtedy to Peter Shor pokazał, jak wykładniczo szybciej rozkładać liczby na czynniki pierwsze, a Lov Grover wykazał, że wyszukiwanie w nieuporządkowanych bazach danych jest kwadratowo bardziej wydajne.

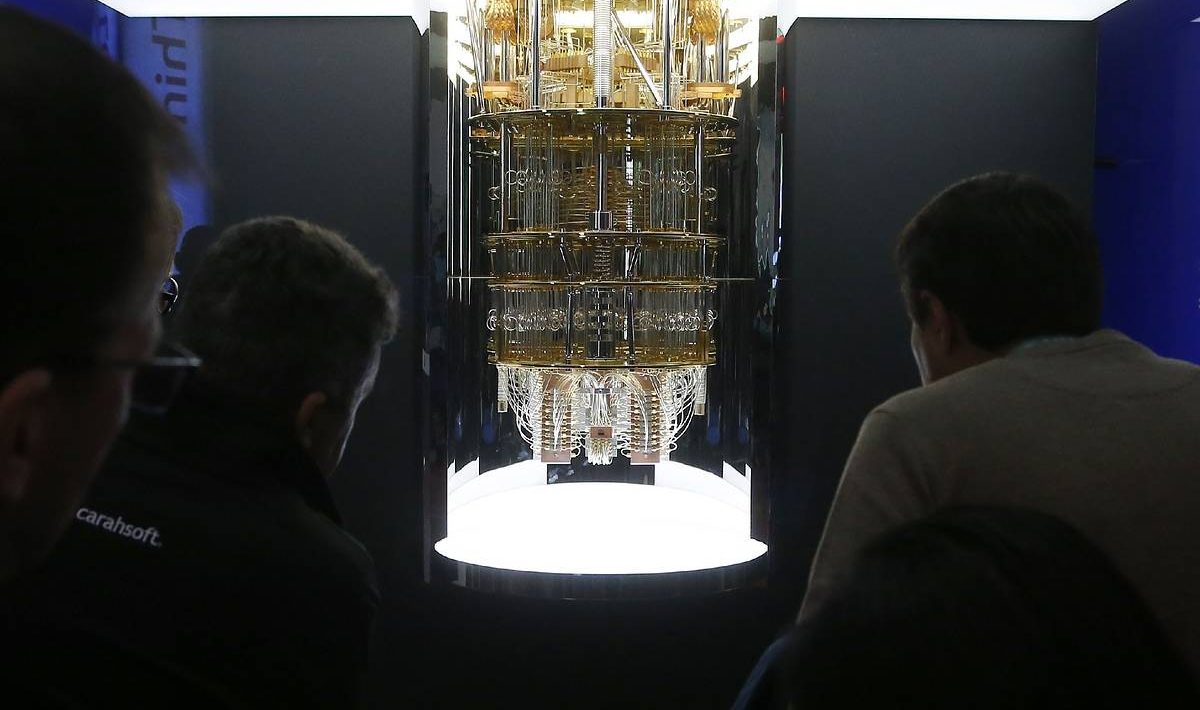

Wraz z nadejściem nowego wieku rozpoczęły się pierwsze praktyczne demonstracje w wielu zastosowaniach. Wśród nich na uwagę zasługuje symulacja prostych cząsteczek, takich jak wodór, w urządzeniach kwantowych. W 2016 roku nastąpił decydujący przełom: IBM Research po raz pierwszy umieścił komputer kwantowy w chmurze, otwierając globalny dostęp do tej technologii. Ten moment zapoczątkował przyspieszony wzrost: liczba firm zajmujących się rozwojem komputerów kwantowych potroiła się, a wiele krajów ogłosiło ambitne krajowe plany inwestycyjne. Najbardziej rzucającą się w oczy była zapowiedź Chin dotycząca megainwestycji o wartości 10 bilionów dolarów w budowę centrum badań kwantowych, co podsyciło geopolityczny wyścig, który trwa do dziś.

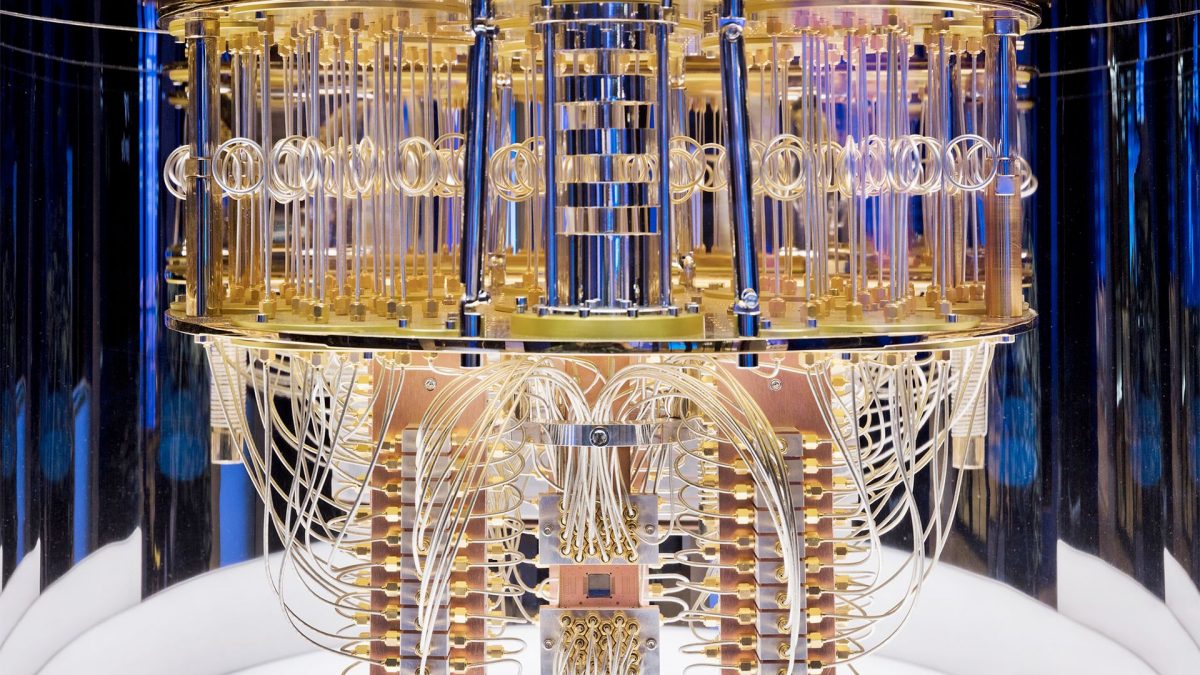

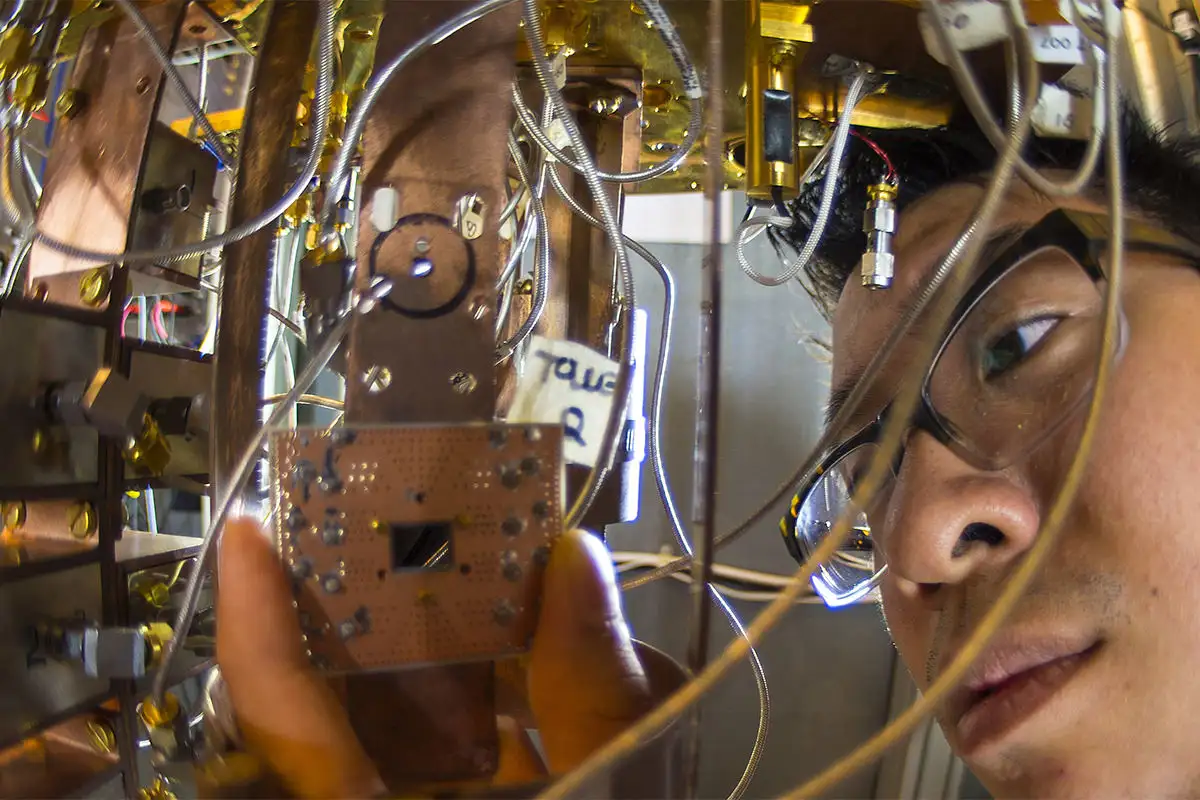

W 2020 r. do rywalizacji dołączyło więcej firm, które rozpoczęły testy koncepcyjne w celu oceny zastosowań w różnych branżach. Testy te pozwoliły zmierzyć dojrzałość sprzętu kwantowego i osiągnąć znaczący postęp w technikach korekcji błędów kwantowych (QEC), które mają fundamentalne znaczenie dla niezawodności działania. Powód jest oczywisty: głównym wąskim gardłem pozostaje utrzymanie spójności kwantowej. Kubity, które zachowują się jak atomy i manipulują spinem elektronów w celu reprezentowania stanów kwantowych, zależą od właściwości superpozycji i splątania. Jednak zachowanie tych właściwości w obliczu wszelkich zewnętrznych oddziaływań jest niezwykle trudne. Z tego powodu stabilność kubitu stała się głównym przedmiotem badań na całym świecie.

W latach 2025–2030 zostanie rozwiązanych wiele niewiadomych dotyczących skalowalności komputerów kwantowych. Nie ma jeszcze jednoznacznie zwycięskiej technologii kubitów: współistnieją podejścia oparte na uwięzionych jonach, fotonach, defektach w diamentach, obwodach nadprzewodzących i innych. Kluczem będzie opracowanie wydajnych chipów kwantowych i bardziej kompaktowych systemów, łatwych w zarządzaniu i znacznie mniej zależnych od ekstremalnych warunków infrastrukturalnych – takich jak ultra niskie temperatury lub złożone systemy elektryczne – do ich działania.

Nie jest jasne, który producent sprzętu będzie w stanie dokonać skoku technologicznego – ogromnego wyzwania produkcyjnego i inżynieryjnego – który, jak opisał w artykule dla Financial Times niedawny laureat Nagrody Nobla w dziedzinie fizyki John Martinis, zadecyduje o przywództwie w tej dziedzinie. W związku z tym Agencja Zaawansowanych Projektów Badawczych w dziedzinie Obronności (DARPA) stworzyła niedawno Inicjatywę Oceny Kwantowej (Quantum Benchmark Initiative). Celem programu jest ustalenie, czy w perspektywie krótkoterminowej (przed 2033 r.) możliwe jest zbudowanie praktycznego i użytecznego dla przemysłu komputera kwantowego. Program ocenia wiarygodność koncepcji komputerów kwantowych poszczególnych firm, analizuje wykonalność ich planów badawczo-rozwojowych i ostatecznie weryfikuje skalowalność przemysłową. Program analizuje 18 firm, wśród których znajdują się zarówno start-upy, jak i duzi producenci – w tym IBM i Google – z USA, Europy, Kanady i Australii. Jego ostatecznym celem jest zapewnienie bezstronnej i zewnętrznej weryfikacji planów działania różnych firm w zakresie budowy odpornego na awarie komputera kwantowego. Pomaga to w zarządzaniu oczekiwaniami, ograniczaniu szumu reklamowego i ukierunkowaniu zainteresowanych stron z rządu USA na realne podejścia do przyszłych inwestycji i kwestii bezpieczeństwa narodowego.

Informatyka kwantowa wkracza w swoją fazę rozkwitu, naznaczoną zmianą paradygmatu, w którym programowanie oznacza operowanie prawami fizyki kwantowej. Jest to moment, który zmusza nas do zastanowienia się, jak się przygotować, jakie umiejętności nabyć i jakie możliwości wykorzystać. Aby pomóc w poruszaniu się po tym nowym etapie, opublikowałam wraz z wydawnictwem Taylor & Francis książkę Quantum Computing Strategy: Foundations and Applicability, która demistyfikuje pojęcia kwantowe i przedstawia przypadki zastosowań w 11 branżach, uporządkowane według obszarów, takich jak optymalizacja, analiza stochastyczna, sztuczna inteligencja i symulacja molekularna. Są to problemy, które obecnie wymagają dużego nakładu obliczeniowego, ale które komputery kwantowe mogłyby rozwiązać w ciągu kilku sekund.